Depuis quelques temps je traîne un WordPress dédié à mes photos, histoire de présenter un peu ce que je fais, sans tout mélanger avec le présent blog. Le truc c'est que WordPress n'est pas fait pour ça. Sa gestion d'images, bien que très correcte pour un CMS, reste limitée. Les thèmes de présentation ne sont pas terribles, je n'en ai jamais trouvé un qui me plaise vraiment.

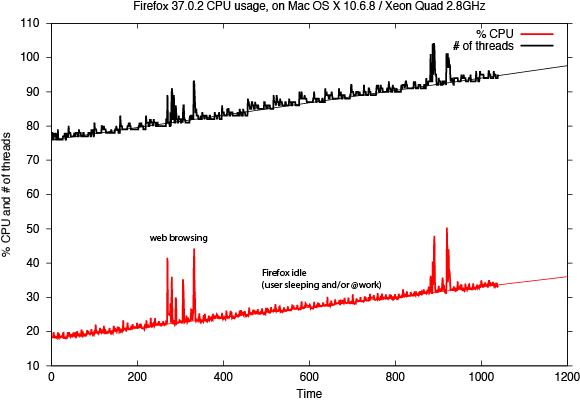

Puis j'en avais marre de ces failles de sécurité presque hebdomadaires : je passe plus de temps à administrer les noyaux WordPress qu'à m'en servir pour publier des choses.

Les thèmes de koken sont aussi entièrement "responsive"

Il était donc temps de changer. Après une courte recherche, je suis tombé presque par hasard sur Koken. Doté d'un scepticisme hors du commun quand il s'agit des applications web, a fortiori codées en PHP, j'ai tout d'abord cru que Koken était comme les autres : mal conçu, plein de parti-pris et de choix techniques imposés par des développeurs plutôt que par des photographes. J'ai approché l'objet avec cautèle, prêt à le vouer aux gémonies et sautant sur la moindre occasion pour râler et montrer du doigt ici un comportement inadmissible ou là une fonctionnalité mal implémentée. "Ha ! Je vous l'avais bien dit" m'apprêtais-je à exulter.

Lâs ! Mal m'en a pris, j'étais dans l'erreur. Koken c'est de la grosse bombe.

C'est tout d'abord une application vraiment bien pensée. Elle atteint un degré de fonctionnalité et d'ergonomie rarement vu sur des applications gratuites, et plus particulièrement dans ce segment (CMS/Portfolio auto-hébergé). Toute sa gestion de contenu est bien conçue, et pour ceux qui utilisent Photoshop Lightroom, l'intégration est poussée au maximum avec la possibilité de publier directement à partir de LR vers ses albums dans Koken. Je ne suis pas fan des applications web qui tentent d'imiter le fonctionnement et l'ergonomie des applications "lourdes". Là encore, je mets ma critique dans la poche, Koken réussi ce pari de fournir une expérience utilisateur quasi parfaite.

Un des principes de base de Koken est de partir de vos photos dans leur version la plus grande et lourde. En général, on publie des photos sur internet sous une taille limitée, pour qu'elles soient légères, plus vite téléchargées et affichées sur l'écran du visiteur. Ici il faut prendre le contre-pied total de cette démarche d'optimisation. En postant l'image la plus grosse possible, vous préparez l'avenir. Vous supportez dès maintenant les écrans "retina", et vous n'aurez pas besoin de republier des photos en haute définition plus tard, quand le débit des connexions aura encore grimpé.

Je viens de le faire : j'ai parcouru mon blog photo WordPress, j'ai fait l'inventaire de toutes les photos publiées, à l'époque en 800px de large, j'ai retrouvé ces photos dans Lightroom, je les ai réexportées dans Koken en grand format. J'avais déjà du le faire en 2012 en passant de PixelPost à WP, c'est incroyablement laborieux, et si mon ancien portfolio avait contenu les fichiers en haute définition j'aurai gagné un temps fou. Mais désormais je suis paré, prêt pour l'avenir.

Sur le plan technique Koken est aussi une application très abordable. Elle ravira tous les photographes qui n'aiment pas bricoler sur un serveur, configurer des bouts de machins, se battre avec des fichiers php. L'installation se fait assez simplement : vous vous assurez de disposer d'une base de données, et vous téléchargez un fichier "index.php" que vous déposez sur un serveur dans son répertoire "koken". Vous accédez ensuite à cette page via un navigateur et vous suivez les instructions.

Et c'est là ma seule et unique réserve au sujet de Koken : la manière pas très transparente qu'ils ont de collecter des informations sur l'utilisateur. En effet, pour installer réellement le logiciel à partir de la page index.php, il faut s'enregistrer (adresse email, nom, prénom, ...). Heureusement on peut toujours donner des informations bidons (même pour l'adresse email). Je trouve le procédé pas très classe. En fait, le produit est tellement bon que je pourrais payer si ça me dispensait de cette procédure d'enregistrement.

Bref, une fois enregistré, tout se fait rapidement : la dernière version de l'application est téléchargée, installée et configurée.

Le travail technique est terminé, il reste le plus dur : décider de votre workflow, de la manière dont vous allez organiser vos photos, des albums, sets, et catégories que vous allez créer pour classer votre production, et bien sûr choisir un thème. Surtout, n'hésitez pas à repousser le choix du thème à la toute fin. Dès que vous avez l'assurance que quelques uns vous plaisent, ne perdez pas de temps dessus et concentrez-vous sur les photos. Revisitez votre bibliothèque Lightroom, décidez quoi faire de vos tags, réfléchissez aux réglages d'import initial des images dans Koken, etc.

Le choix du thème peut vraiment arriver en dernier : certains utilisent les tags, d'autres pas, certains affichent le nom du fichier, d'autres pas, et souvent ils disposent de nombreux réglages, si bien qu'il est probablement plus intéressant de consolider le contenu du portfolio avant de s'attaquer à la présentation.

Pour résumer, je suis totalement conquis (et c'est rare).

De temps en temps, faute de nouvelle parution de mes auteurs favoris, je dois me tourner vers des ouvrages pris un peu au hasard dans les longs rayonnages de

De temps en temps, faute de nouvelle parution de mes auteurs favoris, je dois me tourner vers des ouvrages pris un peu au hasard dans les longs rayonnages de